Shadow IT v éře umělé inteligence: Jak si poradit se shadow AI?

Se snadno dostupnými nástroji založenými na AI zažívá fenomén „shadow IT“ ve firmách další rozmach. Jaká rizika toto „shadow AI“ přináší a jak bychom na ně měli správně reagovat?

Markéta Melenová, Jan Kubíček

Shadow IT v éře AI

V době masivních ochranných opatření proti šíření covidu se stala práce z domova daleko běžnější než kdy předtím v historii. Urychlil se tak přechod na využívání cloudových řešení. Uživatelé od té doby také v mnohem větší míře zpracovávají firemní data na vlastních zařízeních .

Situaci, kdy IT oddělení společnosti ztrácí přehled o tom, které aplikace a řešení jsou ve firmě využívány, se začalo říkat shadow IT. S tímto fenoménem se pojí celá řada rizik – bezpečné nakládání s firemními i osobními daty, zabezpečení jejich přenosu apod.

Trend užívání vlastních ICT nástrojů s posledními proti-pandemickými opatřeními nezmizel. Naopak: nový rozmach shadow IT přišel se snadno dostupnými nástroji založenými na AI. Dnes jde nejčastěji o nástroje generující obsah, které jsou založené na LLM, tzv. genAI. Opět se tak objevuje palčivé téma stínového IT – tentokrát v podobě „shadow AI“.

Co je shadow AI

Jako shadow AI se v prostředí firem označují snadno dostupné generativní AI nástroje (jako veřejné LLM), které se používají, aniž by byly předem schváleny. IT manažeři tak ztrácejí přehled a o to obtížněji se mohou bránit kybernetickým rizikům.

Přístupy IT manažerů k AI nástrojům se přitom liší – od postoje „zakažme to a postupně možná někomu něco povolíme“ až po „vyšla nová verze modelu, proč ji ještě nemáme v produkci?“ Který z nich je správnější?

Jak zavádět AI do organizace?

Při hledání odpovědi vždy vycházíme z existujícího rizikového profilu konkrétní organizace. Správný je totiž ten přístup, který je přiměřený rizikům, obchodním cílům, možnostem (finančním, technickým, obchodním) a aktuálnímu firemnímu know-how v oblasti AI.

Vyvážený přístup tedy znamená zamyslet se nad riziky, nastavit si základní governance proces a pak začít s prvními use cases. Byla by přece škoda vzdávat se vyšší efektivity práce tam, kde mohou AI nástroje dobře posloužit. (Druhou věcí pak je, jak vybrané AI nástroje nasadit a jak je využívat skutečně efektivně.)

Přívětivější postoj k AI nástrojům je typický pro start-upy a organizace, ve kterých je využívání nových technologií součástí jejich DNA a může být i součástí firemní strategie.

V případě organizací s vysokým rizikovým profilem však může být rozumné veřejně dostupné AI nástroje nejprve natvrdo zakázat a znepřístupnit (nespoléhat se jen na interní směrnice a governance proces).

Typicky se to týká finančních institucí a organizací ve vysoce regulovaných či konzervativních sektorech jako zdravotnictví či bankovnictví (i když i mezi nimi se najdou nadšení early adopters). Proč ta opatrnost? Aby se interní informace takových společností neobjevily v odpovědích generovaných AI nástroji mimo organizaci.

IT oddělení pak může postupně povolovat takové AI nástroje, které pracovníci organizace potřebují a které jsou v souladu s firemními zásadami přijatelného používání AI (Acceptable Use AI Policy).

Jaká rizika vyplývají z využívání shadow AI?

Organizace může AI nástroje nasadit na vlastní platformě, kde budou pod její plnou kontrolou (případně si může platit prémiovou verzi s vyššími garancemi ochrany dat).

Protipól představují veřejně a bezplatně dostupné online nástroje, které uživatelé nekontrolovaně používají přímo ve webovém prohlížeči. Dnešní shadow AI má nejčastěji právě tuto podobu. Rizik tím vzniká hned několik.

Reputační riziko

Organizace by ve svých veřejných výstupech mohla prezentovat chybné informace. Rizikové jsou zejména případy, kdy mohou zavádějící nebo chybné informace způsobit lidem zdravotní, finanční a jinou újmu.

Bez rizika není ani interní použití výstupů volných AI nástrojů – obzvlášť v případě, kdy takto vzniknou podklady pro rozhodování.

Rizika pro bezpečnost informací

Aby uživatel získal z AI nástroje užitečné odpovědi, často do něj musí zadat prompt, který může obsahovat citlivé informace. Nikdo v tento moment přitom neví ani nesleduje, co se s nimi následně děje.

Může jít o obchodní tajemství, průmyslové vzory, osobní údaje, finanční informace, informace o tvorbě cen atd. Data se tak dostávají mimo kontrolu organizace, což je nepřijatelné zejména u organizací, které nakládají s vysoce citlivými informacemi.

Existují samozřejmě technická řešení zabraňující exfiltraci dat. Ta nejpřísnější však nemusí být pro některé organizace finančně optimální a pro uživatele přijatelná.

Zajímá vás, jak zajistit bezpečnost v cloudu? O osmi základních principech jsme psali zde.

Užitečná pomůcka pro shadow AI: AWS GenAI Scoping Matrix

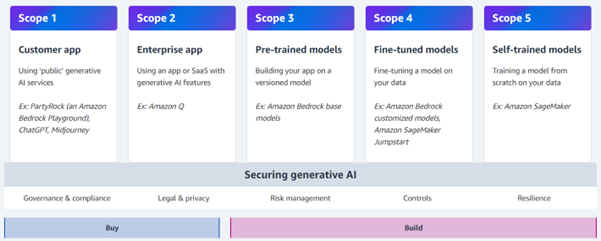

Ve vztahu k shadow AI se nám osvědčil framework vyvinutý AWS. Nazývá se GenAI Scoping Matrix a rozlišuje pět způsobů (nebo přesněji „rozsahů“) implementace nástrojů genAI.

S každým způsobem implementace se pojí odlišný rozsah rizik, a tedy i vhodných bezpečnostních opatření. Model rozsahů rizik a řízení bezpečnosti (scopes) usnadňuje domluvu mezi vývojáři a pracovníky provozní bezpečnosti.

Zahrnuje:

- 2 typy scope, u nichž je řešení pořízeno nákupem (případně je dostupné zdarma – viz dále)

- a 3 typy scope, které jsou vyvinuty podle přání a potřeb zadavatele.

AWS GenAI Scoping Matrix a pět způsobů implementace AI nástrojů (zdroj: Securing Generative AI: Introduction to the Generative AI Security Scoping Matrix)

Nástroje pořizované nákupem

- Scope 1: Zahrnuje používání licencovaných i veřejně dostupných AI řešení (právě tyto nástroje bývají využívané v rámci shadow AI).

Příkladem je živelné využívání nástrojů ChatGPT, Copilot v prohlížeči Edge (dříve Bing Chat) apod. Uživatel (a nevědomě tak i jeho zaměstnavatel) se zde obvykle spoléhá na bezpečnostní opatření poskytovatele nástroje. Prověřil však někdo smluvní podmínky? Zamyslel se někdo nad tím, jak správně a bezpečně nástroj používat?

Uživatelé by do tohoto typu AI nástrojů měli vkládat pouze veřejně dostupná data. Vkládání dat citlivých, dat podléhajících obchodnímu tajemství nebo osobních údajů je nežádoucí.

- Scope 2: AI řešení jsou pořízena organizací jako software as a service (SaaS).

Tyto aplikace umožňují zákazníkům lepší kontrolu nad osudem dat vložených do nástroje, a to včetně možnosti opt-out, tedy odhlášení se z automatického sdílení dat s poskytovatelem nástroje.

(Microsoft 365 Copilot například dědí stávající politiky DLP. Enterprise licence umí respektovat klasifikaci dokumentů i přístupová práva konkrétních uživatelů. Pokud tedy uživatel nemá k něčemu přístup, přístup nemá ani Copilot.) Pro řízení bezpečnosti jsou určující licenční podmínky, jejich dodržování a také disciplína uživatelů při nakládání s daty (některá data nesmějí do AI nástrojů vkládat).

Shadow AI: Může poskytovatel využívat data vašich uživatelů?

Už víme, že shadow AI spadá pod AWS scope 1. Bezpečnost používaných nástrojů je tedy z velké části diktována smluvními podmínkami poskytovatele a tím, jaká data uživatel do nástroje vkládá. Smluvní podmínky každého nástroje jsou přitom specifické.

Příklad 1: Gemini

V podmínkách pro uživatele nástroje Gemini od společnosti Google (dříve Bard) se uvádí, že konverzace a další informace (např. geografická poloha nebo informace o využívání nástroje) jsou automaticky uchovávány a využívány společností Google pro další vývoj a zlepšování těchto technologií.

Pokud si uživatel takové využití dat nepřeje, je potřeba, aby si nástroj řádně nakonfiguroval a z této funkcionality se odhlásil (opt-out). U uživatelů mladších 18 let je naopak zaveden režim opt-in – data se neshromažďují, pokud si to uživatel sám aktivně nenastaví.

Příklad 2: Copilot

Copilot společnosti Microsoft je běžně dostupný v prohlížeči Edge. I zde se v Prohlášení společnosti Microsoft o zásadách ochrany osobních údajů zvídavý uživatel dočte, že jeho data mohou být využita k vývoji a trénování modelů AI společnosti Microsoft.

Dále zde najdeme odkaz na FAQ stránky webové aplikace Copilot, kde naopak v prohlášení poskytovatele stojí, že v případě uživatelů z Evropského hospodářského prostoru (EEA) model vstupy uživatelů pro trénování až do odvolání nepoužívá.

Protože Česká republika je součástí EEA (kde právní rámec takové použití dat omezuje), data českých soukromých uživatelů (ať už přihlášených nebo ne) nejsou pro trénování modelů využívána.

Pokud vás zajímá, zda a jak smějí data cestovat mezi kontinenty, dočtete se více v tomto článku Encyklopedie cloudu.

Shadow AI a smluvní podmínky

Podívejme se ještě na jedno riziko: při používání Microsoft Copilotu ze soukromého uživatelského účtu zaměstnavatel nemůže předpokládat, že si uživatel aktivně zkontroloval podmínky. Situaci zároveň nemůže prověřit, protože o využívání shadow AI nástrojů neví.

Uživatel by si musel podmínky sám vyhledat a musel by je správně interpretovat (což vyžaduje vysokou odbornost a zkušenost v oblasti práva, governance digitálních technologií a bezpečnosti dat). Navíc by musel kontrolu smluvních ujednání provádět proaktivně a průběžně, protože poskytovatelé AI nástrojů provádějí změny podmínek často jednostranně a bez upozornění (není to tedy tak pohodlné jako například u bank, které nám změnu smluvních podmínek dopředu ohlašují).

Cvičené oko právníka si například také všimne:

- že se uvedená omezení vztahují na uživatele „v zemích EEA“, ne však na uživatele „ze zemí EEA“ (jako v případě MS Copilot),

- že se týkají ochrany osobních údajů, ale ne ochrany dat obecně – třeba těch vložených nebo vyprodukovaných modelem (zde je řeč o Gemini),

- že opt-out z využívání dat pro trénování modelů neznamená automaticky opt-out z dalšího používání těchto dat pro jiné účely (opět Microsoft Copilot).

Jak tedy přistupovat k shadow AI?

V případě shadow AI je to nejčastěji uživatel (a ne firma), kdo má ve svých rukou největší míru kontroly nad tím, jak rizikové bude jeho používání genAI nástroje. Jedině uživatel tak může nástroj vhodně nastavit.

Platí, že co je příliš rizikové pro organizaci A, může být pro organizaci B přijatelné. Proto je vhodné přístup k AI nástrojům zaměstnancům spíše umožnit, ale řízeně. Ošetření rizik záleží primárně na obchodních cílech a strategiích organizace, stejně jako na jejím rizikovém profilu.

A protože tohle je naše profesní téma, rádi vám s řízením rizik i se zaváděním AI nástrojů pomůžeme.